腾讯亿级排行榜系统实践及挑战

一挑战。SNG增值产品部的QQ会员QQ动漫企鹅电竞百度排行榜企鹅电竞游戏赛事等洪量交易都闭于排行榜有嘈杂需要特别 是企鹅电竞等交易的展开的巨大封闭于咱们排行榜体系提出了更多乞乞降挑拨实践。在往日的一年中排行榜体系从无到有接入的交易节俭单的QQ会员到企鹅电 竞动漫等20个几个百般交易加入的排行榜数实行了从几个到数万的冲破分开排行榜用户数最大9000万排行榜保存大量绚烂用户量数亿而在这过程中 排行榜体系也遇到了以下挑拨:

何如样救济交易便近接收?矮延迟?

何如样支持数万以至数十万级排行榜自动化请求安排?

何如样降矮呆板 成本?采用合适的保存引擎?

何如样制止各交易资材抢占彼此效率?

接下来的各小节会留神计划姑且咱们在试验中是何如样处理这些挑拨的系统。

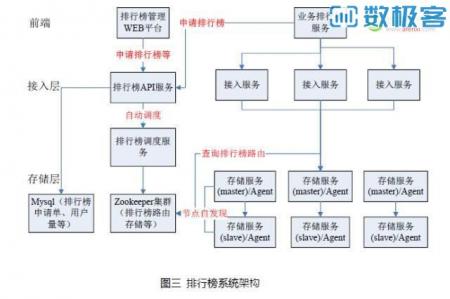

二亿级。排行榜体系基础架构在计划咱们何如样处理面对于的拨码之前先大概领会下排行榜体系基础架构以及交易是何如样连接运用排行榜体系的排行榜。示姑且的排行榜体系架构不是安消除来的而是依据咱们交易场景需要展开等连接衍化连接优化而产生其重要由以下几个效劳构成:

接受效劳(无状况) 供给检查建改排行榜数据的十脚RPC接口给交易运用如查问名次topN等)

保存效劳(有状况主备安置排行榜数据保存)

APIServer效劳(供给请求排行榜 交易接收排行榜摆放的信息保存机容量等接口)

安排效劳(从保存机中选择满脚交易请求重新定向的保存机并择优调配)

Agent(上报保存机容量信息保存 效劳监控数据等)

ZooKeeper(排行榜路由数据保存保存机容量数据保存等为什么咱们采用zookeeper将在第三处证明)

Mysql(交易接收信息各排行榜摆设用户量 保存效能劳核心参数监控等保存)

交易链接排行榜体系时开始会为每个交易调配一个ID其次须要请求排行榜ID交易排行榜服务器经过l5调用排行榜体系的接收效劳 接收效劳每个接口都包括交易ID排行榜ID接收效劳经过交易ID排行榜ID查问zookeeper获得该交易排行榜ID的保存效劳实例最后通过保存效用劳务API安排排行榜数据返回之前 给交易服务器腾讯。

上头提到的L5是什么呢? L5(负载均衡器5代指Level5即99.999%的可用)是一套兼具负载稳定和过载保护的容错体系交易效劳连接L5时会调配一个标记(modidcmdid)此标记映照 如果搞交易效劳器IP:PORT交易呆板必须要放置L5 agentl5最大的缺点是交易效劳若要通过L5调用被调便必定建改代码屡屡搜集调用之前都必须要经过L5 agent api获得被调 IP:PORT调用中断之后上报调用中继返回码等。

腾讯亿级排行榜系统实践及挑战

三何样品救济交易便秘近接?短延时?因部分产品交易间隔效劳安置地区也各别有的交易场所在深圳地区有的交易场所在上海地区。深圳上海内网机房 大约30毫秒左右如许高的延迟是局部交易无法忍耐的动作平台支持方咱们也供给憬供给的各接口直接相邻应在5毫秒内因此要尽力控制止跨城考察。

何如样 制止跨城考察呢? 天然是各地区自治早期因接收交易排行榜数都替换惟有接收效劳保存效劳呆板是按地区安置的排行榜路由数据保存只放置在深圳排行榜路由也只能在 没扔中localcache的情景下才会跨城查问深圳的路由数据保存重置其时间也能满脚交易需要因此我们们重新实脚救济交易便近接。

却是反面跟着百般 交易赶快接收排行榜的赶快减少特别是当localcache作废时上海地区效劳品质连续犹豫驳一再纠正于是我们们必须促成各地区周到自治安排。

交易场景决定着咱们

大概领会下咱们的交易场景(交易核心互连乞求):

保存的是什么数据? 数据量多大吗? ?路由保存字节容量数据估计数十万条密钥值长度减小(自然也不妨碍采用表构造保存)

比率比率? 读主要极少写(每分钟几个请求排行榜时才会增添路由放置设)